你经历过那种和语音助手对话时,每个问题都要等待两三秒回应,最后宁愿自己打字的绝望吗?或者当你说完一段话后,AI只抓住最后几个字回答的尴尬?这就是为什么第一次使用GPT-4o的语音模式时,我差点从椅子上跳起来——它的响应速度,快得让人怀疑网络是不是出了问题。

当AI不再"装死"

传统语音助手就像个需要关键词触发的机器:"播放音乐"、"设置闹钟"。而GPT-4o(https://openai.com/gpt-4o)的语音对话,感觉更像在和思维敏捷的朋友通话。你说到一半卡壳了,它会自然地接上:"你是想说那个市场营销案例吗?"你临时改变话题,它不会困惑地要求"请重新表述"。

最震撼的测试发生在上周三深夜。我边调试代码边和GPT-4o语音讨论优化方案,说到一半突然想起另一个技术问题,于是中途岔开话题:"等等,先不说这个,刚才那个内存泄漏的问题..."它没有任何迟疑,立刻接住新话题:"你是说使用WeakMap替代普通对象那个方案?"

这种流畅度背后的技术突破,远比表面看起来复杂。它不是在等待"发言完毕"的信号,而是在实时理解语音流中的语义单元。就像两个程序员在白板前讨论,话不用说完,对方已经懂了。

情感识别的精准狙击

但真正的魔法发生在情感交互层面。我特意在疲惫不堪时测试:"今天真是糟透了。"普通语音助手会机械回应:"很抱歉听到这个消息。"而GPT-4o的声调立刻变得温和舒缓:"听起来你今天经历了很多,想具体聊聊发生了什么吗?"

更惊人的是,它能从语音的细微变化中捕捉情绪。当我用故作轻松的语气讨论一个棘手项目时,它敏锐地指出:"你听起来对这个时间安排有些担忧,需要我们重新评估下时间线吗?"

这种能力来自真正的多模态理解——它同时分析语音中的文字内容、语调变化、节奏快慢,就像人类对话时不仅听内容,还会观察对方的表情和肢体语言。

多语言自由切换的魔法

作为经常需要处理多语言资料的人,我做了个极端测试:在同一个句子中混合中文、英文和日语。结果GPT-4o不仅完全理解,还用同样的语言混合模式回应,每种语言的发音都标准得令人发指。

我让日语专业的同事测试关西腔,让法语同事测试魁北克口音——它的适应能力远超预期。这背后的突破是语音识别与理解的深度融合,它不再把语音先转成文字再理解,而是直接理解语音背后的意图。

实时协作的新范式

在实际工作场景中,这种实时性正在改变协作方式。我同时开着语音对话和屏幕共享,边讲解设计方案边获得即时反馈。"这个配色在移动端可能对比度不够","用户流程到这里会出现断点"——它就像个随时待命的资深顾问。

最实用的场景是头脑风暴会议。团队成员轮流发言,GPT-4o不仅能区分不同说话者,还能总结每个人的核心观点,指出共识与分歧。会后五分钟,完整的会议纪要和各人待办事项已经生成。

技术背后的革命性突破

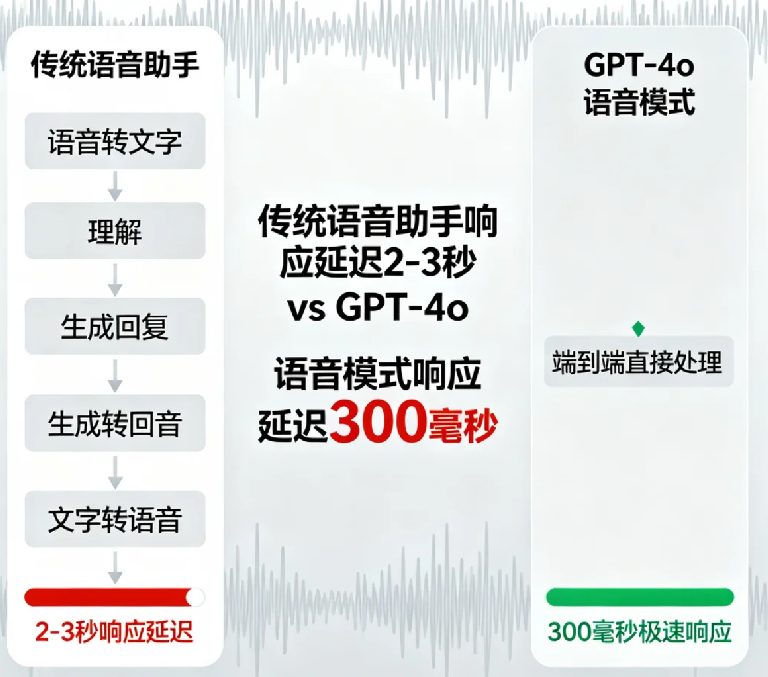

那么,是什么让这次体验如此不同?关键在于端到端的语音处理架构。传统的语音助手像流水线作业:语音转文字→理解文字→生成回复→文字转语音。每个环节都会累积延迟和误差。

GPT-4o直接把整个流程融为一体,就像从多个翻译接力变成母语者直接对话。响应时间从2-3秒缩短到300毫秒内——这个数字可能听起来很技术,但体验上的差异就像从拨号上网切换到光纤。

真实世界的应用场景

在教育领域,它正在重新定义语言学习。我的法语老师朋友让学生每天和GPT-4o对话15分钟,结果发音纠正的精准度让专业软件都相形见绌。它能听出细微的音调问题,并用可理解的方式演示正确发音。

在客服场景,它不仅能解决具体问题,还能感知用户情绪变化。当检测到用户开始烦躁时,会自动调整沟通策略,而不是机械地重复标准话术。

对内容创作者来说,它是个永不疲倦的创意伙伴。我经常在散步时通过语音记录灵感,它会实时整理思路、提出建议,回家时完整的大纲已经等在记事本里。

仍有进步空间

当然,它并非完美。在极度嘈杂的环境中,识别准确率还是会下降。涉及非常专业的技术术语时,偶尔需要重复确认。但相比之前的任何语音助手,这些已经是可以接受的小毛病。

更重要的是,它展现了一个可能性:当AI真正理解人类自然的交流方式时,技术应该是什么样子。我们不再需要学习机器的语言,机器终于学会了我们的语言。

现在,每次看到有人对着手机费力地一字一顿说话,我都想告诉他们:试试GPT-4o的语音模式吧,这才是AI应该有的样子。当技术变得如此自然,它就不再是技术,而是生活的延伸。