Ollama 是一个开源的 LLM(大型语言模型)服务工具,它旨在简化在本地运行大语言模型的过程,降低使用大语言模型的门槛。Ollama 支持多种大语言模型,如 Qwen2、Llama3、Phi3、Gemma2 等,并且支持从远程仓库下载模型到本地。它提供了用户友好的界面和简单的命令,使得从业余爱好者到开发者的广泛用户群体都能轻松使用

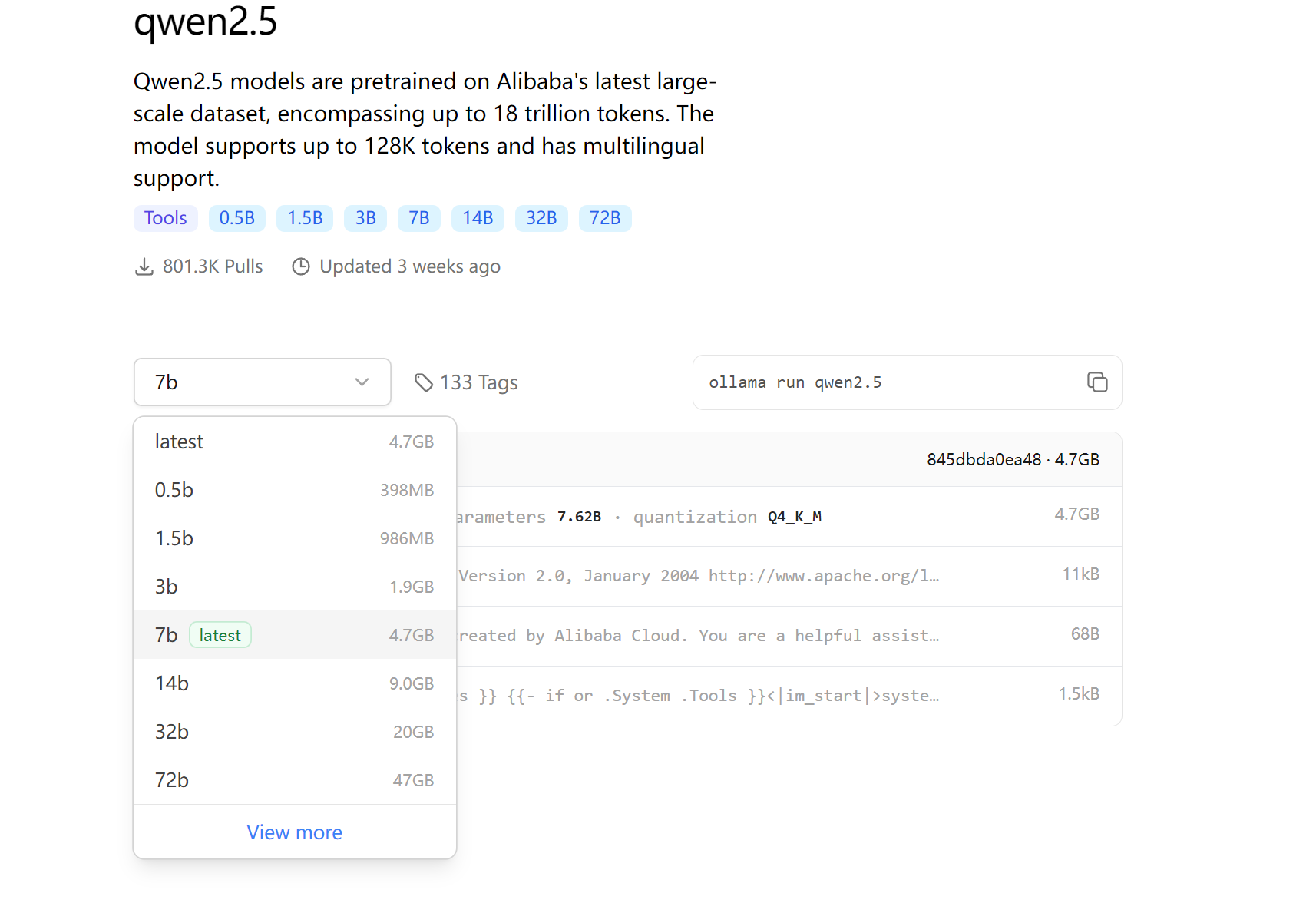

ollama下载完成后,点models 去下载大模型选择qwen2.根据自己电脑的配置选择不同的大模型型号

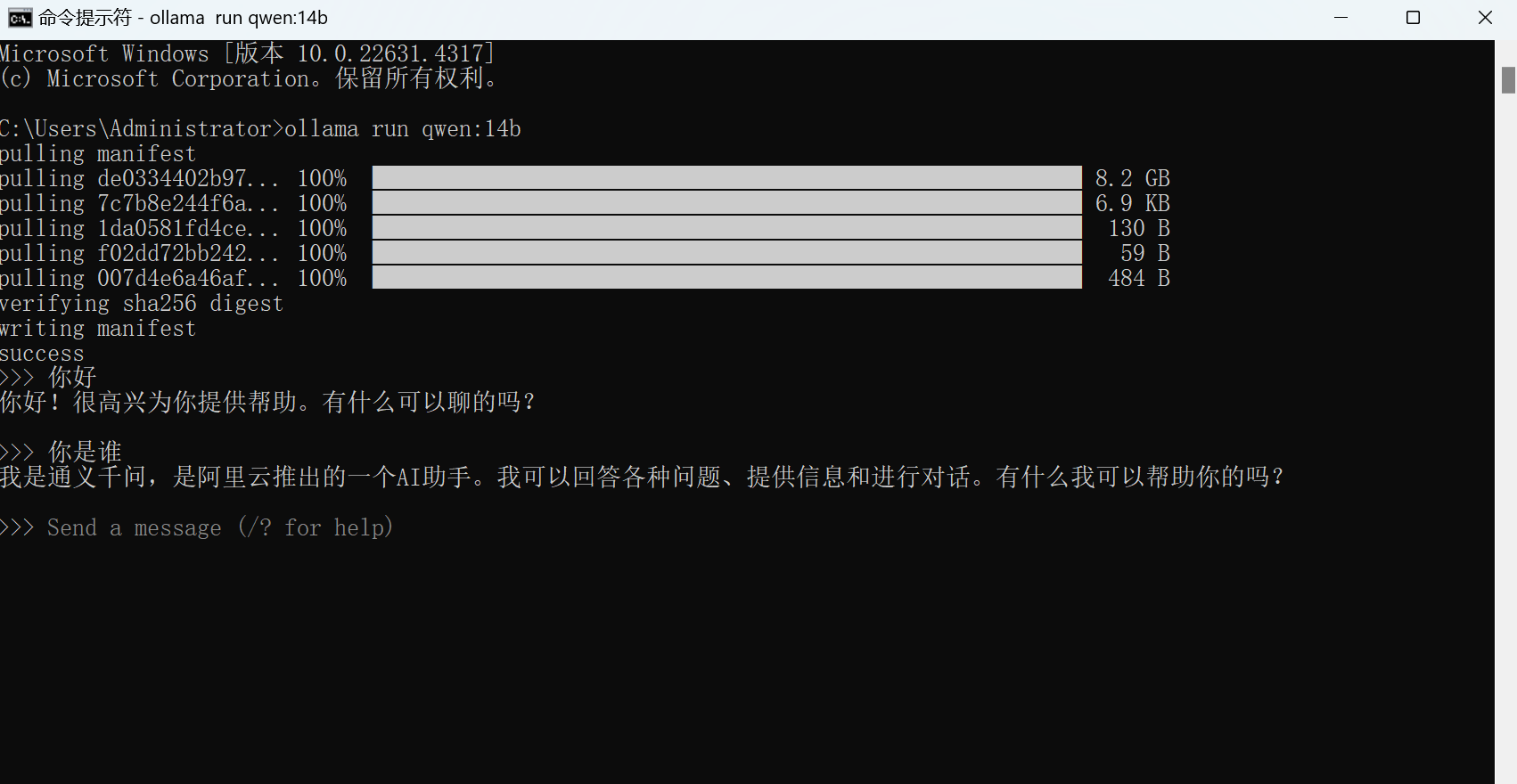

前面完成后打开windows命令提示符 运行ollama run qwen2.5:14b

安装完成以后就可以进行使用了。

Ollama 的特点包括:

- 支持多种操作系统,包括 Windows、MacOS 和 Linux。

- 提供了丰富的 API 和库支持,包括 Python 和 JavaScript 库,以及 CLI 和 REST API。

- 支持从多种格式导入模型,如 GGUF、PyTorch 和 Safetensors。

- 提供了一个模型库,用户可以轻松选择和使用预训练的模型。

- 允许用户通过 Modelfile 自定义模型参数和行为。

安装 Ollama 后,用户可以通过简单的命令行界面来管理、运行和部署大模型。例如,使用 ollama run [模型名] 命令来运行选定的模型,并通过 ollama models 命令查看可用的模型列表。

Ollama 还提供了一些高级定制功能,如使用 Modelfile 客製化模型,以及通过环境变量进行服务器配置。此外,Ollama 还重视用户的安全和隐私保护,使用 SSL/TLS 加密传输数据,并提供访问控制列表(ACL)来限制对服务的访问。

总的来说,Ollama 是一个强大而灵活的工具,旨在让大型模型的部署和管理变得更加便捷和高效